„Furtul de voce”. Experiența înfricoșătoare a unei jurnaliste care a devenit victima unei fraude cu AI

Georgina Findlay, o jurnalistă și prezentatoare a canalului YouTube TLDR News, specializat în transmiterea știrilor într-o manieră simplificată, a povestit, într-un articol de opinie din The Guardian, cum i-a fost folosită vocea, fără consimțământ, pentru promovarea de mesaje ale extremei drepte, prin intermediul inteligenței artificiale.

Fratele jurnalistei a fost cel care a remarcat prima dată că vocea ei fusese folosită într-un context cu totul neașteptat. „Ți se va părea înfiorător”, a avertizat-o el. Un clip de pe instagram, care arăta un adolescent la un miting avea suprapusă o voce caracteristică celor care transmit emisiunile de știri. O voce calmă, feminină, cu un accent de Manchester aproape imperceptibil, a spus: „Recentul strigăt al unui student britanic a devenit un simbol puternic al unei crize a sistemului educațional din Marea Britanie care se tot adâncește”.

„În calitate de prezentator pentru un canal de știri YouTube, eram obișnuită să-mi aud vocea pe ecran”, a explicat Findlay. „Numai că nu eram eu – chiar dacă vocea era incontestabil a mea”. Vocea asociată clipului deplângea faptul să sistemul de educație britanic îi obligă pe elevi să învețe despre islam și Mahomed la școală.

„A fost înfricoșător să-mi aud vocea asociată cu propaganda de extremă-dreaptă – dar mai mult decât atât, pe măsură ce am săpat mai departe modul în care este comisă această înșelătorie, am descoperit cât de extinse pot fi consecințele unui audio fals”.

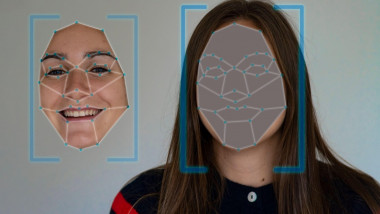

Clonarea vocii prin AI este o formă emergentă de „deepfake” audio și a treia escrocherie cu cea mai rapidă creștere a incidenței din 2024. Victimele, fără să știe, își găsesc vocea reprodusă în mod profesionist, fără consimțământul sau chiar cunoștința lor, iar fenomenul a dus deja la ocolirea controalelor de securitate bancare și la fraudarea oamenilor pentru a trimite bani unor străini, despre care credeau că sunt rude. În cazul lui Findlay, fratele său primisese clipul de la un prieten care îi recunoscuse vocea.

După ce a făcut investigații, Findlay a reușit să găsească sursa clipului la un canal YouTube de extremă dreapta, cu aproximativ 200.000 de abonați. Se presupune că era un canal american, dar multe dintre greșelile de ortografie de pe videoclipuri erau tipice conturilor de dezinformare care nu vorbeau limba engleză.

„Am fost îngrozit să constat că opt din 12 dintre cele mai recente videoclipuri ale canalului mi-au folosit vocea. Am găsit un videoclip cu vocea mea de acum cinci luni, care avea un număr de vizionări de 10 milioane. Vocea suna aproape exact ca a mea. Cu excepția faptului că a existat un ritm ușor ciudat în discursul meu, semn că vocea a fost generată de inteligența artificială”, a explicat jurnalista.

Acest software-ului de clonare a vocii AI din ce în ce mai sofisticat este un motiv de îngrijorare gravă. În noiembrie 2023, un deepfake audio al primarului Londrei, Sadiq Khan, care ar fi făcut remarci incendiare despre Ziua Armistițiului, a fost difuzat pe scară largă pe rețelele sociale. Clipul aproape că a dus la „tulburări grave”, a spus Khan pentru BBC. „Momentul nu ar fi putut fi mai bun dacă voiai să semeni dizarmonie și să provoci probleme.”

Într-o perioadă în care încrederea în sistemul politic al Regatului Unit este deja la cel mai scăzut nivel, 58% dintre britanici spunând că „aproape niciodată” nu au încredere în politicieni să spună adevărul, a putea manipula retorica publică nu a fost niciodată mai dăunător.

Dreptul legal de a-ți deține vocea se încadrează într-o zonă gri tulbure de probleme de AI nereglementate. Naturalistul britanic David Attenborough a fost în centrul unui scandal de clonare a vocii în noiembrie. Attenboroughs-a descris ca fiind „profund deranjat” să descopere că vocea lui este folosită pentru a livra buletine de știri partizane din SUA; în mai, actrița Scarlett Johannson a avut o confruntare cu OpenAI după ce un model text-to-speech al produsului său, ChatGPT, a folosit o voce pe care Johansson a descris-o ca fiind „îngrozitor de asemănătoare” cu a ei.

În martie 2024, OpenAI a amânat lansarea unui nou instrument de clonare a vocii, considerându-l „prea riscant” pentru lansarea generală într-un an cu un număr record de alegeri globale. Unele startup-uri de AI care permit utilizatorilor să-și cloneze propria voce au introdus o politică de precauție, permițându-le să detecteze crearea de clone de voce care imită personalități politice implicate activ în campaniile electorale, începând cu cele din SUA și Marea Britanie.

Dar acești pași de atenuare nu merg suficient de departe. În SUA, senatorii îngrijorați au propus un proiect de lege care ar lua măsuri împotriva celor care reproduc audio fără consimțământ. În Europa, Sistemul European pentru Observarea Furtului de Identitate (Eithos) dezvoltă patru instrumente pentru a sprijini poliția în identificarea falsurilor, care speră să fie gata în acest an. Dar abordarea crizei audio în Marea Britanie nu va fi o sarcină ușoară, atrage atenția Georgina Findlay. Dr. Dominic Lees, expert în AI folosit în film și televiziune, care consiliază o comisie parlamentară din Marea Britanie, a declarat pentru The Guardian: „Legile noastre privind confidențialitatea și drepturile de autor nu sunt la zi cu ceea ce prezintă această nouă tehnologie”.

Dacă scăderea încrederii în instituții este o problemă, creșterea neîncrederii în rândul comunităților este alta. Capacitatea de a avea încredere este esențială pentru cooperarea umană în viața noastră personală și profesională din ce în ce mai globalizată, din ce în ce mai împletită – cu toate acestea, nu am fost niciodată atât de aproape de a o submina. Hany Farid, profesor de criminalistică digitală la Universitatea din California din Berkeley și expert în detectarea deepfake-urilor, a declarat pentru Washington Post că consecințele acestei crize audio ar putea fi la fel de extreme precum violența în masă sau „fraudarea alegerilor”.

Ar putea exista vreun avantaj la această nouă capacitate de a clona voci cu ușurință? Poate. Clonele vocale AI ne pot permite să căutăm confort prin conectarea cu cei dragi care au murit sau să ne ajute să le dăm voce celor cu afecțiuni medicale. Actorul american Val Kilmer care a făcut tratament pentru cancerul de gât, a revenit în 2022 pentru Top Gun: Maverick cu o voce restaurată de AI.

Editor : Ș.R.

- Etichete:

- frauda

- inteligenta artificiala

- deepfake

Urmărește știrile Digi24.ro și pe Google News